La finalidad de este documento es describir el paso a paso de la instalacion de

un Solaris 11_2 en un servidor sparc M5000

Todo este procedimiento fue realizado con los siguientes elementos:

Notebook Olivetti con sistema operativo linux Ubuntu 14.04.2 LTS, Trusty Tahr, dentro de la misma, le instale Oracle Virtual Box, con sistema operativo Solaris 11_1 x86

Preparacion previa en mi notebook

En el linux de mi notebook , en el directorio /home/coneja/Downloads/ tengo las imagenes .iso del dvd

Dentro del Oracle Virtual Box, hay una opcion que se llama "shared folders", ahi

le digo que fs o directorio quiero compartir a mi solaris ( NO hacerlo en modo read only )

En mi caso, el fs compartido fue /home/coneja/Downloads

***Aclaracion importante: cuando creo en el VirtualBox el Solaris, debo hacerlo

con la opcion de red "Bridge " para que funcione cuando lo conecte al server qu

e quiero instalar ***

Cuando levanta el solaris, monta automaticamente los fs que comparti desde el Virtual Box anteriormente

Bajar de la web de oracle, el repositorio de solaris 11.

Son 4 archivos .zip mas un script instal-repo.ksh y un README

sol-11_2-repo-1of4.zip

sol-11_2-repo-2of4.zip

sol-11_2-repo-3of4.zip

sol-11_2-repo-4of4.zip

Cuando Levanto el solaris de mi maquina virtual, automaticamente monta

el filesystem que le indique en el shared folders.

Luego lo que hice fue , asignarle un disco virtual al solaris 11

que estan en mi Virtual Box (Esto se hace con el solaris 11 del VBox apagado ).

Genere un zpool llamado repopool , el cual sera destino de el repositorio

de parches.

Para esto, los comandos utilizados en el solaris11 de mi VBox fueron

zpool create -f repopool c7t2d0s0

zpool list

zfs set mountpoint=/repo

El paso siguiente fue, en el solaris 11 de mi VBox, pararme en el fs compartido

/home/coneja/Downloads y ejecutar el install-repo.ksh ( tal como esta en la foto siguiente)

Este script, hace un md5 checksum de los archivos que baje, posteriormente realiza un uncompress de los archivos .zip y genera un solo.iso que alojara en el

filesystem compartido

/home/coneja/Downloads que fue donde estaba parado cuando ejecute el script .

En el fs de mi solaris11 de la VBox /repo/ dejara todo el contenido del iso pero ya listo para usar.

Todo este procedimiento tardo 11 horas, es muy lento.

# svccfg -s application/pkg/server setprop pkg/inst_root=/repo/repo

# svccfg -s application/pkg/server setprop pkg/readonly=true

# svcadm refresh application/pkg/server

# svcadm enable application/pkg/server

Aca le agrego la ip de mi VirtualBox con Solaris

root@sol11vm:/export/home# pkg set-publisher -O http://192.168.30.1 solaris

root@sol11vm:/export/home# pkg publisher

PUBLISHER TYPE STATUS P LOCATION

solaris origin online F http://192.168.30.1/

root@sol11vm:/export/home# pkgrepo refresh -s /repo

Initiating repository refresh.

Chequeo que pueda ver el contenido, buscando algun paquete, uso el viejo y querido xclock de ejemplo

root@sol11vm:/export/home# pkg search xclock

INDEX ACTION VALUE PACKAGE

basename file usr/share/X11/app-defaults/XClock pkg:/x11/xclock@1.0.6-0.175.1.0.0.24.1317

basename file usr/bin/xclock pkg:/x11/xclock@1.0.6-0.175.1.0.0.24.1317

basename link usr/X11/bin/xclock pkg:/x11/xclock@1.0.6-0.175.1.0.0.24.1317

pkg.description set xclock is the classic X Window System clock utility. It displays the time in analog or digital form, continuously updated at a frequency which may be specified by the user. pkg:/x11/xclock@1.0.6-0.175.1.0.0.24.1317

pkg.fmri set solaris/x11/xclock pkg:/x11/xclock@1.0.6-0.175.1.0.0.24.1317

pkg.summary set xclock - analog / digital clock for X pkg:/x11/xclock@1.0.6-0.175.1.0.0.24.1317

root@sol11vm:/export/home# zfs list

NAME USED AVAIL REFER MOUNTPOINT

repopool 8.35G 32.8G 8.34G /repo

rpool 25.6G 5.37G 4.58M /rpool

rpool/IPS 11.6G 5.37G 11.6G /IPS

rpool/ROOT 4.49G 5.37G 31K legacy

rpool/ROOT/solaris-1 4.49G 5.37G 2.22G /

rpool/ROOT/solaris-1/var 1.29G 5.37G 1.20G /var

rpool/VARSHARE 84.5K 5.37G 84.5K /var/share

rpool/dump 792M 5.39G 768M -

rpool/export 7.73G 5.37G 711M /export

rpool/export/home 7.03G 5.37G 7.03G /export/home

rpool/export/home/gojea 35.5K 5.37G 35.5K /export/home/gojea

rpool/swap 1.03G 5.40G 1.00G -

root@sol11vm:/export/home# zfs create repopool/ai

root@sol11vm:/export/home# zfs list

NAME USED AVAIL REFER MOUNTPOINT

repopool 8.35G 32.8G 8.34G /repo

repopool/ai 31K 32.8G 31K /repo/ai

rpool 25.6G 5.37G 4.58M /rpool

rpool/IPS 11.6G 5.37G 11.6G /IPS

rpool/ROOT 4.49G 5.37G 31K legacy

rpool/ROOT/solaris-1 4.49G 5.37G 2.22G /

rpool/ROOT/solaris-1/var 1.29G 5.37G 1.20G /var

rpool/VARSHARE 84.5K 5.37G 84.5K /var/share

rpool/dump 792M 5.39G 768M -

rpool/export 7.73G 5.37G 711M /export

rpool/export/home 7.03G 5.37G 7.03G /export/home

rpool/export/home/gojea 35.5K 5.37G 35.5K /export/home/gojea

rpool/swap 1.03G 5.40G 1.00G -

root@sol11vm:/export/home# zfs get -r dedup repopool

NAME PROPERTY VALUE SOURCE

repopool dedup on local

repopool/ai dedup on inherited from repopool

root@sol11vm:/export/home# zfs mountpoint=repopool/ai

root@sol11vm:/export/home# ls -ltrh /mnt/sf_coneja/Downloads/

total 34186824

-rw-r----- 1 root vboxsf 500M Jun 6 21:04 sol-11_2-ai-sparc.iso

-rw-r----- 1 root vboxsf 731M Jun 7 21:03 sol-11_2-text-sparc.iso

-rwxr-xr-x 1 root vboxsf 5.5K Jun 7 22:49 install-repo.ksh

-rw-r----- 1 root vboxsf 1.8G Jun 7 22:50 sol-11_2-repo-2of4.zip

-rw-r----- 1 root vboxsf 3.1K Jun 7 22:50 README-zipped-repo.txt

-rw-r----- 1 root vboxsf 228 Jun 7 22:51 sol-11_2-repo-md5sums.txt

-rw-r----- 1 root vboxsf 1.8G Jun 8 00:27 sol-11_2-repo-3of4.zip

-rw-r----- 1 root vboxsf 1.7G Jun 8 13:22 sol-11_2-repo-4of4.zip

-rw-rw-r-- 1 root vboxsf 1.7G Jun 8 22:09 sol-11_2-repo-1of4.zip

-rw-r--r-- 1 root vboxsf 406K Jun 12 06:32 mkiso.log

-rw-r--r-- 1 root vboxsf 8.2G Jun 12 06:32 sol-11_2-repo.iso

sol11vm:/export/home# cp -pr /mnt/sf_coneja/Downloads/sol-11_2-ai-sparc.iso /ai

root@sol11vm:/export/home# ls -ltrh /ai

total 757116

-rw-r----- 1 root vboxsf 500M Jun 6 21:04 sol-11_2-ai-sparc.iso

root@sol11vm:/export/home# svcs -a|grep dns

disabled 16:02:37 svc:/network/dns/client:default

disabled 16:02:40 svc:/network/dns/multicast:default

disabled 16:02:41 svc:/network/dns/server:default

root@sol11vm:/export/home# svcadm enable dns/client

disabled 16:02:40 svc:/network/dns/multicast:default

disabled 16:02:41 svc:/network/dns/server:default

offline* 9:57:25 svc:/network/dns/client:default

root@sol11vm:/export/home# svcs -a|grep dns

disabled 16:02:41 svc:/network/dns/server:default

online 9:57:35 svc:/network/dns/client:default

online 9:57:58 svc:/network/dns/multicast:default

root@sol11vm:/ai#

# installadm create-service -n sol11-2-ai -i 192.168.30.10 -c 10 -s /ai/sol-11_2-ai-sparc.iso /ai/sol11-2-ai.target

Creating service from: /ai/sol-11_2-ai-sparc.iso

OK to use default image path: /export/auto_install/sol11-2-ai? [y/N]: y

Setting up the image ...

Creating sparc service: sol11-2-ai

Image path: /export/auto_install/sol11-2-ai

Service discovery fallback mechanism set up

Creating SPARC configuration file

Adding IP range to local DHCP configuration

Unable to add IP range: check_subnet_for_overlap: adding range causes

overlap on subnet

192.168.30.0

The install service has been created but the DHCP configuration has

not been completed. Please see dhcpd(8) for further information.

Refreshing install services

FINALIZADA la preparacion previa de la notebook , se viene la instalacion de solaris 11.2 en el servidor m5000

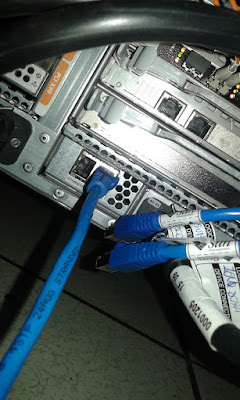

Conectar el cable de red de la notebook al IOU0 red interna del m5000

Conectar el cable usb serial a mi notebook y el otro extremo al serial del equipo

desde el linux, tipear

minicom -D /dev/ttyUSB0 ( esto depende en que usb lo conecte, lo verifico con un dmesg )

Esta configuracion fue la que funciono con el minicom, modifico lo sig:

Serial device : /dev/ttyUSB0

BPS : 9600 8N1

Hardware FLOW control : YES

Software Flow Control NO

Una vez que se conecta el minicom, voy a estar parado en la XSCF del M5000

lo tengo que llevar a OBP con lo s siguientes comandos

Puedo chequear primero si se ven entre el M5000 y mi linux , desde el linux con el comando ethtool eth0 como lo muestro en la foto

XSCF> console -d 0

pongo la clave de root y le doy init 0 .

En el caso que no tenga la clave de root, me vuelvo a la XSCF con la combinacion de teclas #. ( numeral + punto )

XSCF> reset -d 0

desde OBP ejecuto boot net:dchp - install ( CUIDADO, respetar los espacios y el guion - antes de install sino falla la instalacion porque no encuentra el boot image)

En la foto de arriba muestra que termino la instalacion del miniroot y esta booteando el solaris 12

En la foto de abajo , muestro como esta instalando desde la imagenes

Listo, ya instalado, ejecuto un pkg update y compruebo que esta todo.

Una vez que finaliza la instalacion hay que hacer un init 6

Esta instalacion te deja en el sys.unconfig y ahi hay que configurar el

hostname, el TIMEZONE, etc.

Una vez booteado de disco, hay que agregar la ip, configurar el defaultrouter,etc.

Para configurar la ip seria

root@psunp006:~# dladm show-link

LINK CLASS MTU STATE OVER

net3 phys 1500 unknown --

net0 phys 1500 unknown --

net4 phys 1500 unknown --

net2 phys 1500 unknown --

net5 phys 1500 unknown --

net1 phys 1500 unknown --

root@psunp006:~# netadm enable -p ncp defaultfixed

ncp 'DefaultFixed' is already enabled

root@psunp006:~# dladm show-phys

LINK MEDIA STATE SPEED DUPLEX DEVICE

net3 Ethernet unknown 0 unknown e1000g1

net0 Ethernet unknown 0 unknown bge0

net4 Ethernet unknown 0 unknown e1000g2

net2 Ethernet unknown 0 unknown e1000g0

net5 Ethernet unknown 0 unknown e1000g3

net1 Ethernet unknown 0 unknown bge1

root@psunp006:~# ipadm

NAME CLASS/TYPE STATE UNDER ADDR

lo0 loopback ok -- --

lo0/v4 static ok -- 127.0.0.1/8

lo0/v6 static ok -- ::1/128

sppp0 ip ok -- --

sppp0/? static ok -- 192.168.200.2->192.168.200.1

root@psunp006:~#

root@psunp006:~# ifconfig -a

lo0: flags=2001000849

inet 127.0.0.1 netmask ff000000

sppp0: flags=1010010008d1

inet 192.168.200.2 --> 192.168.200.1 netmask ffffff00

ether 0:0:0:0:0:0

lo0: flags=2002000849

inet6 ::1/128

root@psunp006:~#

root@psunp006:~# ipadm create-ip net0

root@psunp006:~# ipadm create-addr -T static -a local=10.77.100.212/24 net0/addr

root@psunp006:~# ipadm show-addr

ADDROBJ TYPE STATE ADDR

lo0/v4 static ok 127.0.0.1/8

sppp0/? static ok 192.168.200.2->192.168.200.1

net0/addr static inaccessible 10.77.100.212/24

lo0/v6 static ok ::1/128

root@psunp006:~#

root@psunp006:~# ifconfig -a

lo0: flags=2001000849

inet 127.0.0.1 netmask ff000000

sppp0: flags=1010010008d1

inet 192.168.200.2 --> 192.168.200.1 netmask ffffff00

ether 0:0:0:0:0:0

net0: flags=1000803

inet 10.77.100.212 netmask ffffff00 broadcast 10.77.100.255

ether 0:21:28:1a:75:20

lo0: flags=2002000849

inet6 ::1/128

net0: flags=20002000800

inet6 ::/0

ether 0:21:28:1a:75:20

root@psunp006:~#

root@psunp006:~# route -p add default 10.77.100.1

add net default: gateway 10.77.100.1

Este equipo ya tenia storage conectado, asi que el paso siguiente que hice fue poner los discos conectados a la SAN , en multipath

root@psunp006:/kernel/drv# stmsboot -D fp -e

WARNING: This operation will require a reboot.

Do you want to continue ? [y/n] (default: y) y

The changes will come into effect after rebooting the system.

Reboot the system now ? [y/n] (default: y) y

psunp006 console login: syncing file systems... done

rebooting...

Resetting...

POST Sequence 01 CPU Check

POST Sequence 02 Banner

LSB#00 (XSB#00-0): POST 2.9.0 (2009/02/18 14:34)

POST Sequence 03 Fatal Check

POST Sequence 04 CPU Register

POST Sequence 05 STICK

POST Sequence 06 MMU

POST Sequence 07 Memory Initialize

POST Sequence 08 Memory

POST Sequence 09 Raw UE In Cache

POST Sequence 0A Floating Point Unit

POST Sequence 0B SC

POST Sequence 0C Cacheable Instruction

POST Sequence 0D Softint

POST Sequence 0E CPU Cross Call

POST Sequence 0F CMU-CH

POST Sequence 10 PCI-CH

POST Sequence 11 Master Device

POST Sequence 12 DSCP

POST Sequence 13 SC Check Before STICK Diag

POST Sequence 14 STICK Stop

POST Sequence 15 STICK Start

POST Sequence 16 Error CPU Check

POST Sequence 17 System Configuration

POST Sequence 18 System Status Check

POST Sequence 19 System Status Check After Sync

POST Sequence 1A OpenBoot Start...

POST Sequence Complete.

Sun SPARC Enterprise M5000 Server, using Domain console

Copyright 2008 Sun Microsystems, Inc. All rights reserved.

Copyright 2008 Sun Microsystems, Inc. and Fujitsu Limited. All rights reserved.

OpenBoot 4.24.10, 32768 MB memory installed, Serial #86543492.

Ethernet address 0:21:28:28:8c:84, Host ID: 85288c84.

Rebooting with command: boot

Boot device: /pci@0,600000/pci@0/pci@8/pci@0/scsi@1/disk@0,0:a File and args:

SunOS Release 5.11 Version 11.2 64-bit

Copyright (c) 1983, 2014, Oracle and/or its affiliates. All rights reserved.

stmsboot: Root is on ZFS

stmsboot: configuring devices

stmsboot: vfstab has been updated

stmsboot: now regenerating boot archive

Hostname: psunp006

*********************************************************************************

Este trabajo lo realize con la ayuda de mi colega Nicolas Morono.

Agradezco la ayuda y soporte de los Fied Engineer Marcelo Herrera y Guillermo Ojea Quintana

*********************************************************************************